Hey Leute,

die Pixel Smartphones von Google sind als besondere Smartphones, die nicht dem Trend des Marktes hinterherrennen, immer eine große Diskussion in der Tech-Szene. Sie sind bei der Kamera bekannt dafür, aus schlechter Hardware durch Software viel rauszuholen und waren daher lange der Marktführer. Daher reden wir heute über diese, am Beispiel des Google Pixel 4. Mein Review zu diesem Smartphone wird in wenigen Wochen noch erscheinen.

Erst: Danke an O2 für die Bereitstellung des Testgerätes. ![]()

Viel Spaß beim Lesen!

Wie immer habe ich für die lesefaulen unter euch noch ein YouTube-Video:

Hardware - Wie immer schwach

Hardwareseitig verwendet Google bei einem 2019-Smartphone wieder den 12MP IMX363 Hauptsensor. Zum ersten Mal hat Google beim Pixel 4 auch eine Dual-Kamera angewendet, entschied sich für eine Zoomkamera, benutzt aber einen Sensor, der als Ultraweitwinkel bekannt geworden ist. 50mm Brennweite, also fast 2x optischer Zoom, 16MP und OIS.

Ehm, also als sehr häufiger Nutzer einer Ultraweitwinkelkamera fühle ich mich schon etwas angegriffen...

Ultraweitwinkel |  Kein Ultraweitwinkel |

zumal man den 2x Zoom auch mit Software erreichen kann, (besonders Google, wozu wir gleich noch kommen werden), einen Ultraweitwinkel ist aber nicht durch Software erreichbar.

Als Vergleich nehme ich hier mein Huawei P40. Erstens, weil es das Beste ist was ich aktuell hier habe, aber auch weil es in derselben Produkt- & Preiskategorie mitspielt und weil Huawei für die Kamera bekannt ist. Dennoch wird hier ein riesiger Sensor angewendet, anders als bei Google.

Software-Design

Die Software ist meiner Meinung nach sehr schlicht und schön designet. Fehlen tut mir ein Pro-Modus. Das Auslösen geht schnell und die Zoomkamera wurde so perfekt integriert, dass man sie überhaupt nicht bemerkt. Das ist mindestens Apple Niveau. Die Vorschau ist mit dem Ergebnis immer identisch, das ist schön, allerdings ist die Schärfe des View-Finder eher verbesserungswürdig. Nicht so schlimm wie bei Huawei, aber auch nicht sonderlich gut. Flüssig ist er auch nicht besonders, aber den Kompromiss gehe ich bei LiveHDR+ ein.

Bild-Ergebnisse im Vergleich

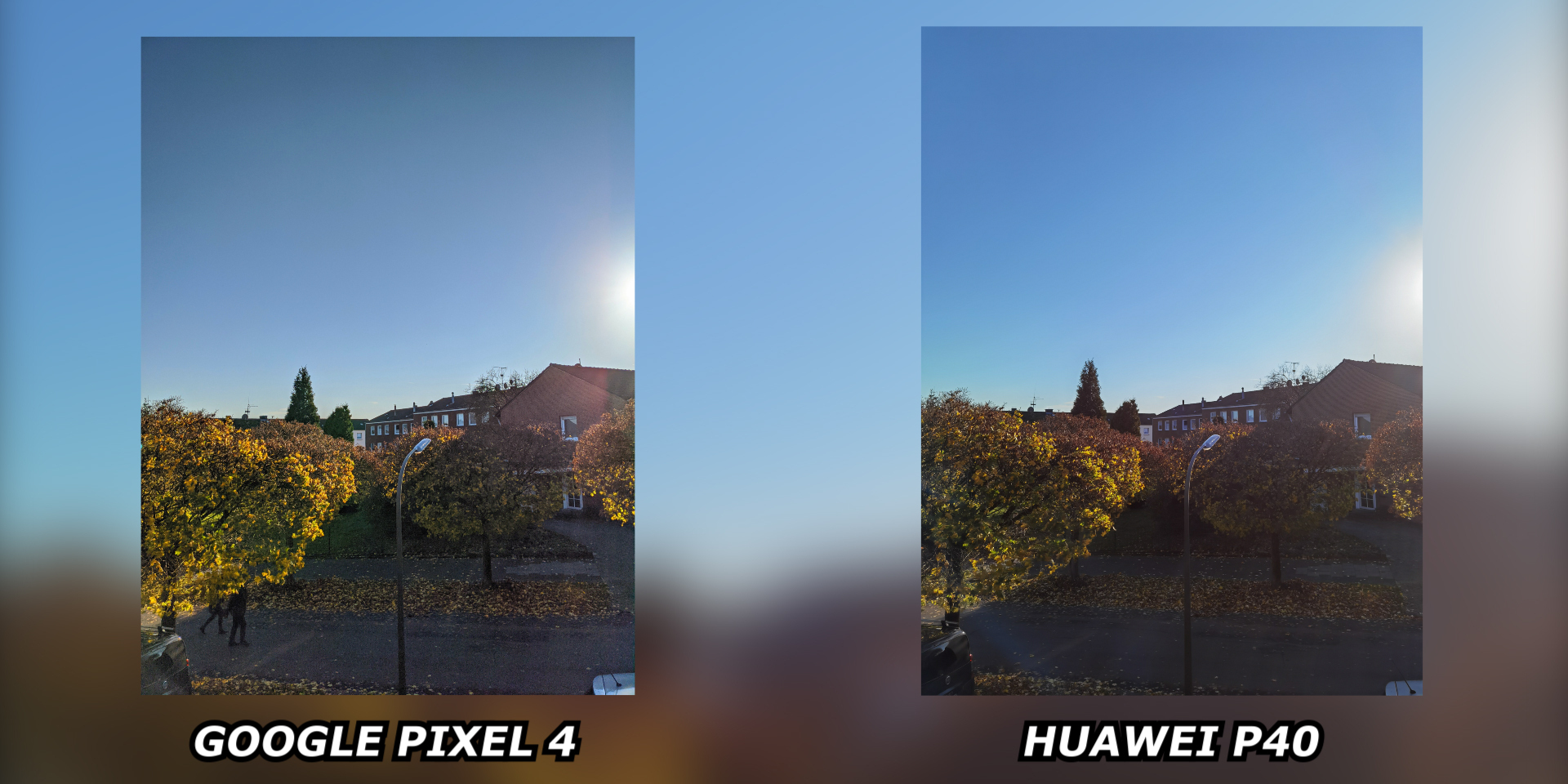

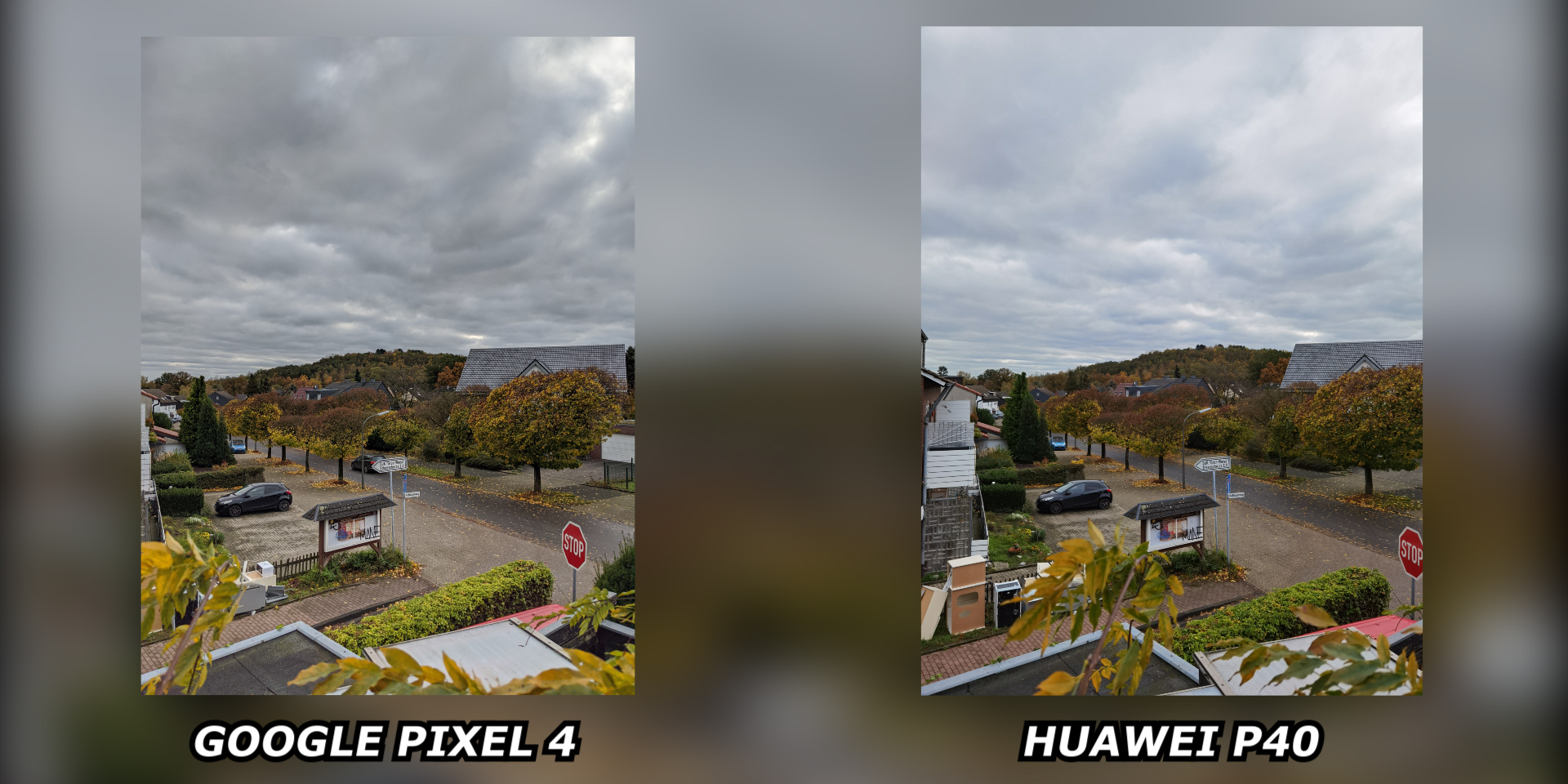

Zunächst fällt beim ersten Betrachten der Ergebnisse schon auf, dass Google das HDR richtig gut hinbekommen hat. Mit der hellen Sonne kann das Pixel 4 gut umgehen und die Farben des Himmels sind auch gut geblieben. Besonders unter dem Himmel hat Google eine viel hellere Szene mit mehr zu sehen. Huawei dreht hier die Sättigung nach oben, der Himmel wird noch blauer. Sieht gut aus, aber zum Beispiel bei der Straße hat Google dadurch die realistischeren Farben und man kann aus einer Bearbeitung mehr rausholen. |

|

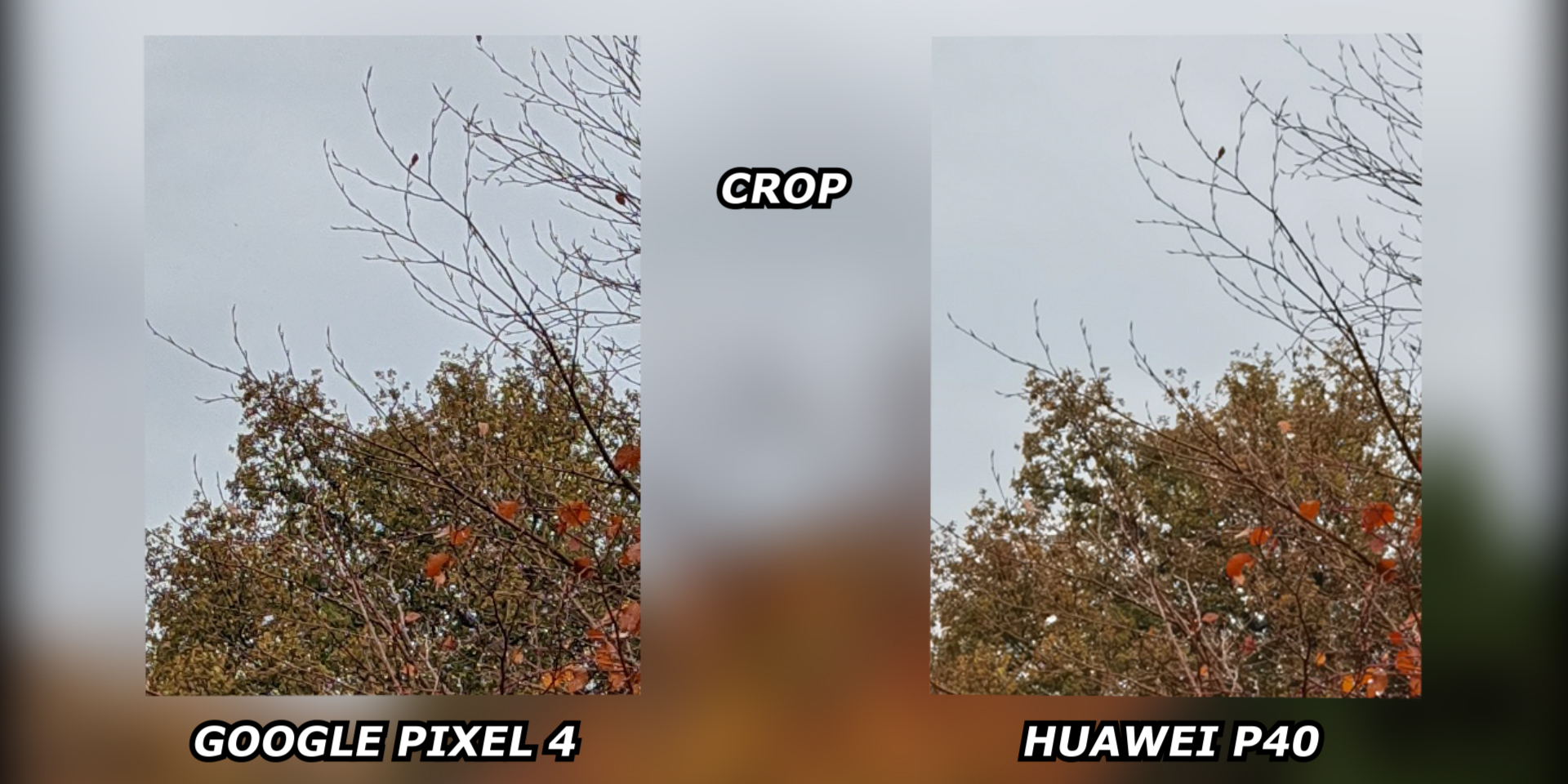

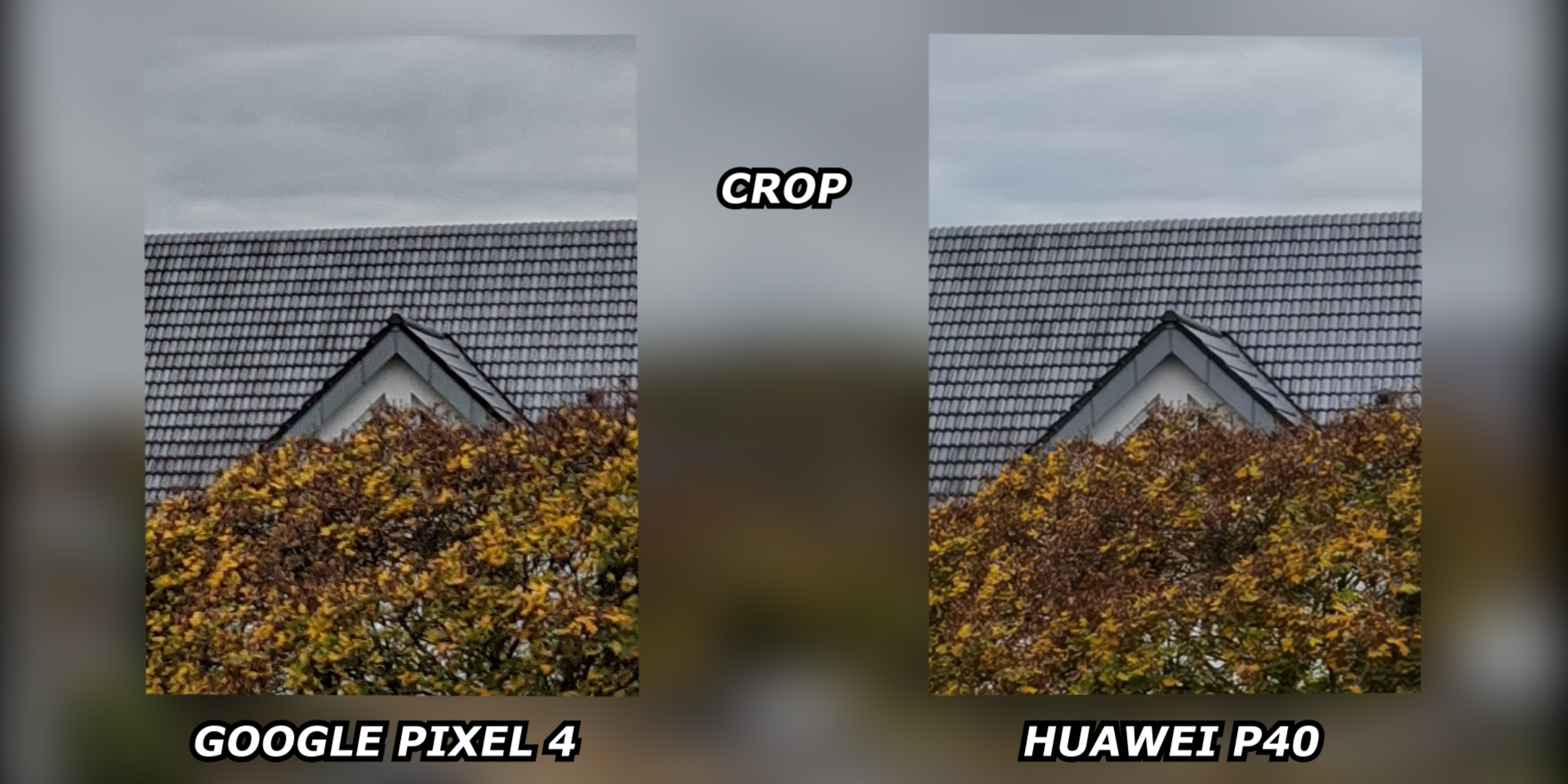

Nun mal zu der Schärfe: Hier spielt Google eine Liga über den Konkurrenten, ohne vollständig manuell zu überschärfen. Schaut euch das Bild in groß an, indem ihr drauf klickt. Beide Smartphones haben ein 12MP Bild, Google aber viel mehr Details.

|

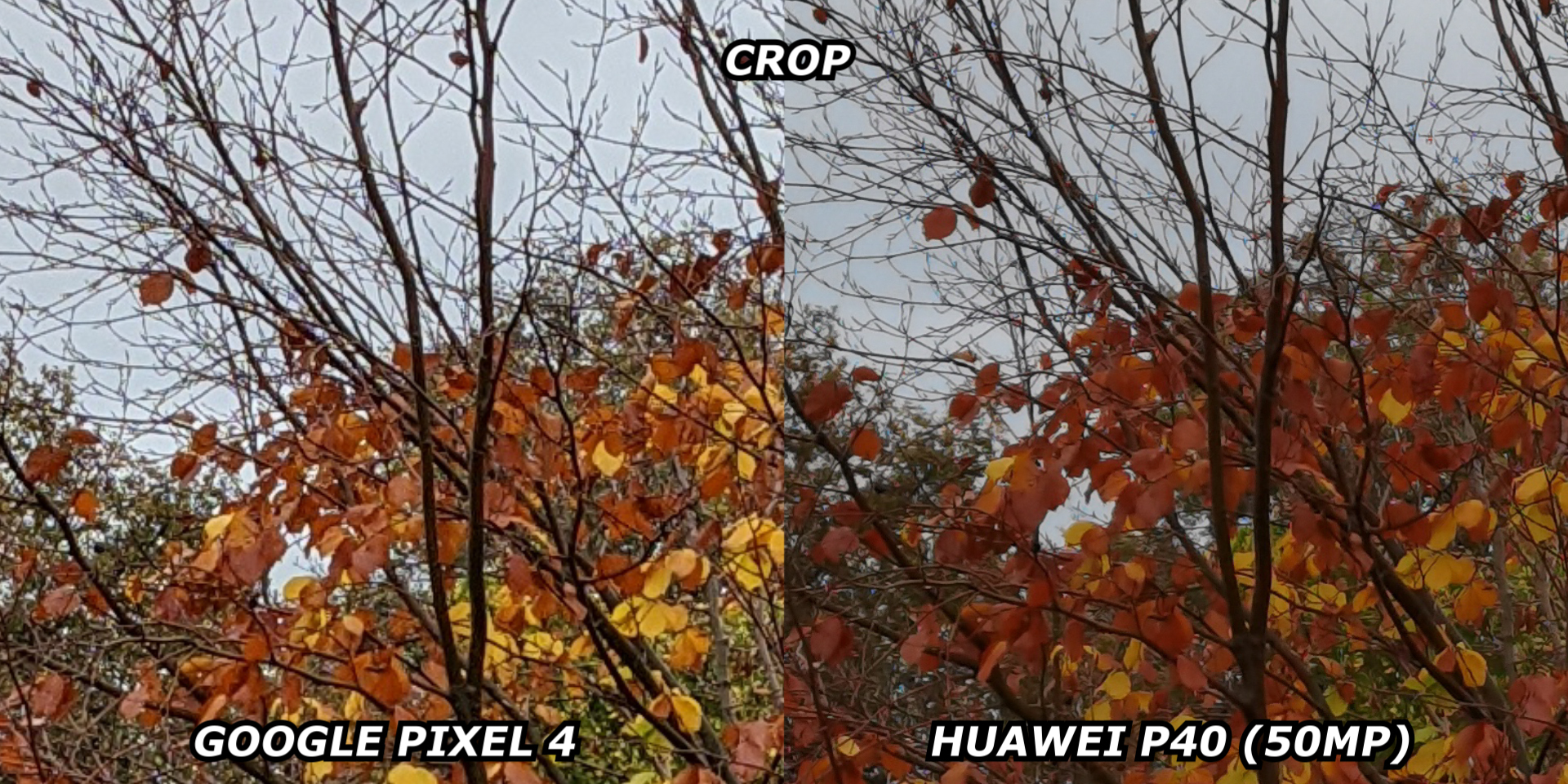

|  Natürlich ist der Unterschied zum 50MP Modus des P40 noch sichtbar, aber bei diesem wird viel verwaschen. |

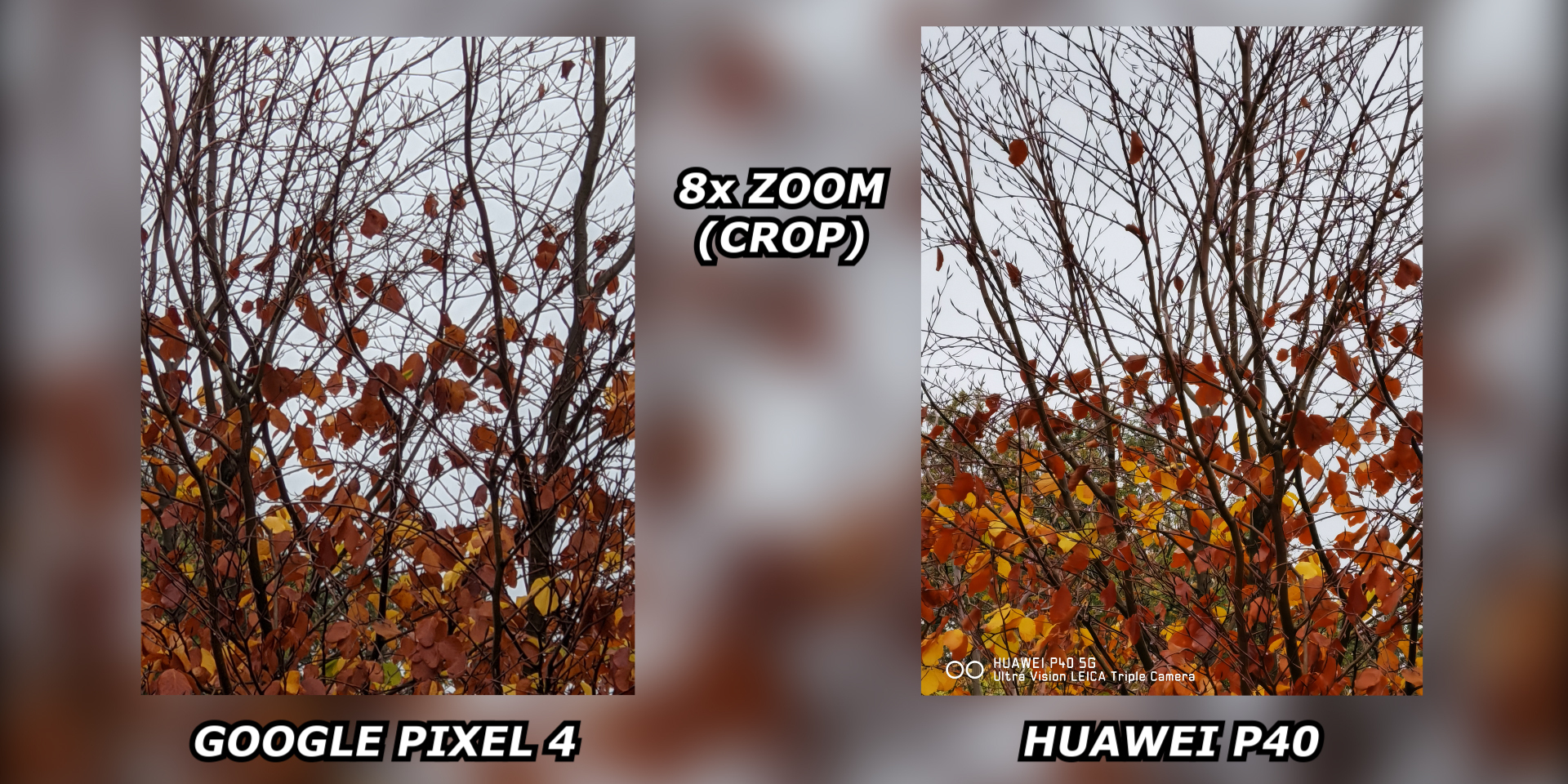

Zudem wirkt sich das auch auf den digitalen Zoom aus:

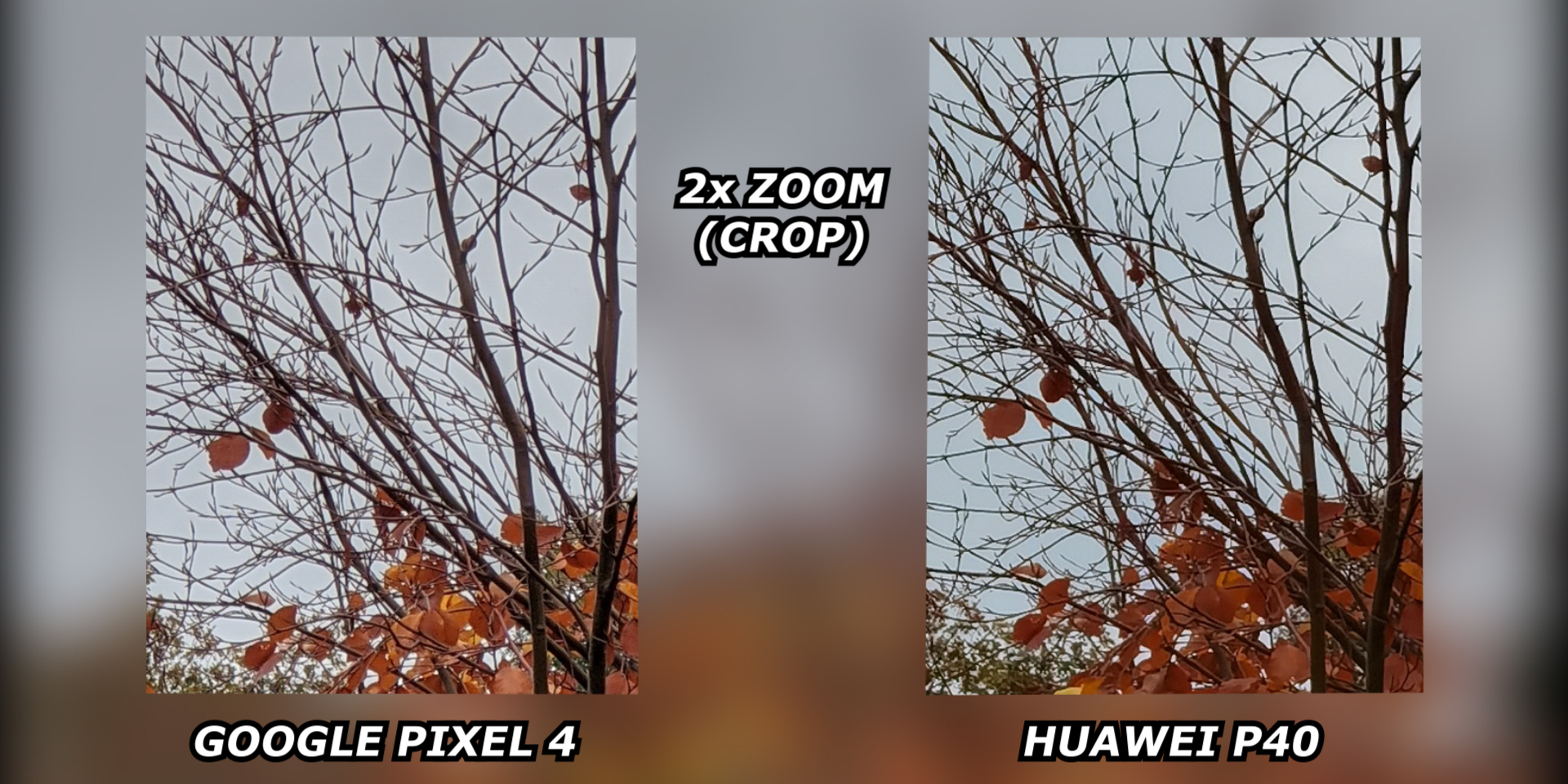

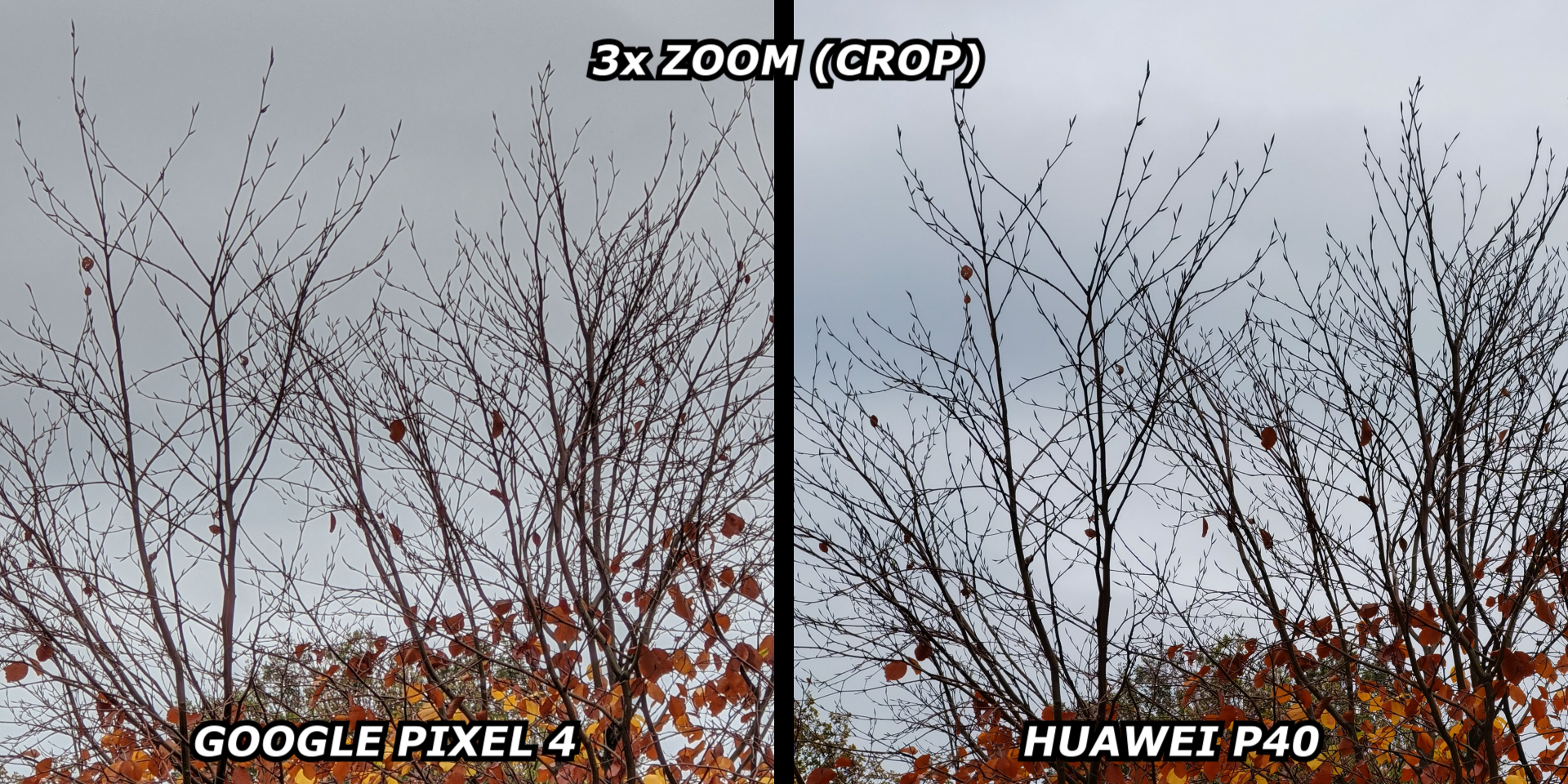

Bei 2x Vergrößerung brauchen wir nicht vergleichen, da das Pixel hierfür eine extra Kamera hat, also kleiner Vorteil. |  Aber bei 3x Vergrößerung zum Beispiel ist der Unterschied zum optischen Zoom des P40 gar nicht mal so groß. |  Erst bei wirklich höheren Zoomstufen holt sich Huawei den Vorteil zurück. Google ist aber dennoch besser als die meisten anderen Handys. |

Woher solche Vorteile? - Erste Technologie: LiveHDR+

Unter schlechteren Bedingungen große Vorteile bei den Ergebnissen, das muss an der Software liegen. Also kommen wir endlich zu dem Hauptthema des Beitrags.

Beim Öffnen der Kamera App auf dem Pixel Smartphone sehen wir im View-Finder bereits das Live HDR+ angedeutet, wohinter die HDR+ Burst Technologie steckt. Hier nimmt die Software bereits im Sucher mit gleicher, absichtlich niedriger Belichtung und Verschlusszeit Bilder auf und behält diese im Cache, einem temporären Speicher.

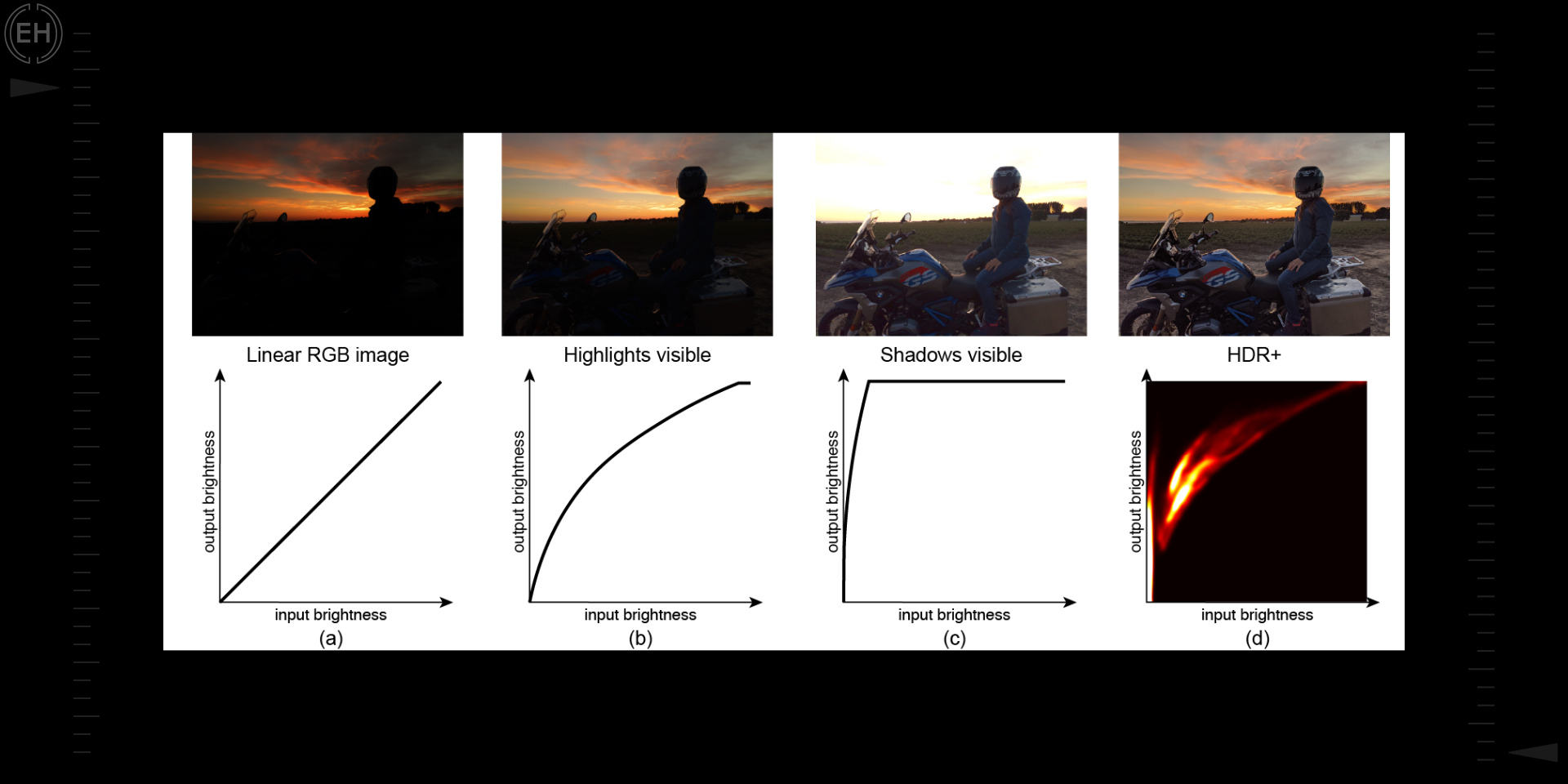

Die Bilder werden so kombiniert und gerendert, dass ein temporäres linear RGB Image mit 14bit Farben und extrem vielen Details erhalten bleiben. Diese kann man hier jedoch aufgrund des zu hohen Dynamikumfangs noch nicht erkennen. Daher werden alle Pixel mit einer bestimmten Helligkeit einer neuen zugeordnet. Das HDR-Ergebnis am Ende hat Details sowohl in den Schatten, als auch in den hellen Bereichen des Bildes.

Bis zu dem Pixel 3 war es noch nicht möglich, diese Bilder in Echtzeit bei bis zu 30 Bildern pro Sekunde zu verarbeiten. Also konnten sie es nicht im Sucher anzeigen, weswegen Google erst beim Pixel 4 durch maschinelles Lernen LiveHDR+ vorgestellt hat, welches ein HDR+ mit Echtzeitvorschau beschreibt.

|

|

Neu sind auch die zwei Helligkeitsschieber. Während der obere mit der Sonne als Symbol wie früher die Helligkeit des gesamten Bildes verstellt, kümmert sich der untere Slider um die Schatten, er hellt nur diese auf oder dunkelt nur diese ab.

Noch beeindruckender - Super Res Zoom

Die hohe Schärfe und der gute digitale Zoom sind zudem noch der Technologie Super Res Zoom zu verdanken. Das ist nicht mehr nur noch das Zusammenfügen mehrerer Bilder, sondern eine viel tiefere Technologie.

Das besondere hierbei ist, das Google das kleine Wackeln der menschlichen Hand, die eigentliche Schwierigkeit beim mobilen Fotografieren, als Lösung verwendet. Hättest du nicht erwartet, oder? Keine Sorge, wir reden mal darüber, wie Google so etwas hinbekommen hat. Das erste Problem zu lösen sind die verlorenen Farb-Informationen.

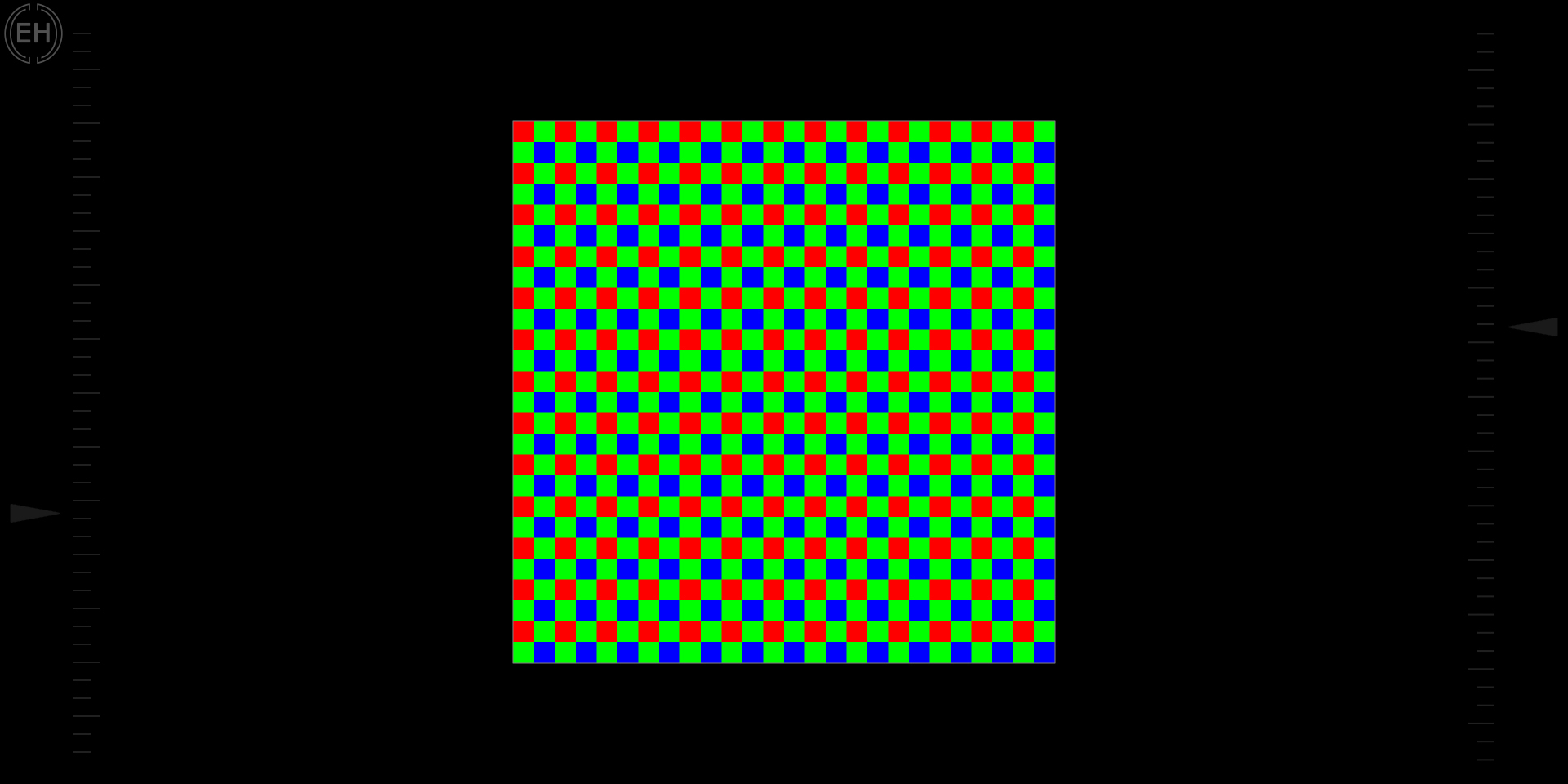

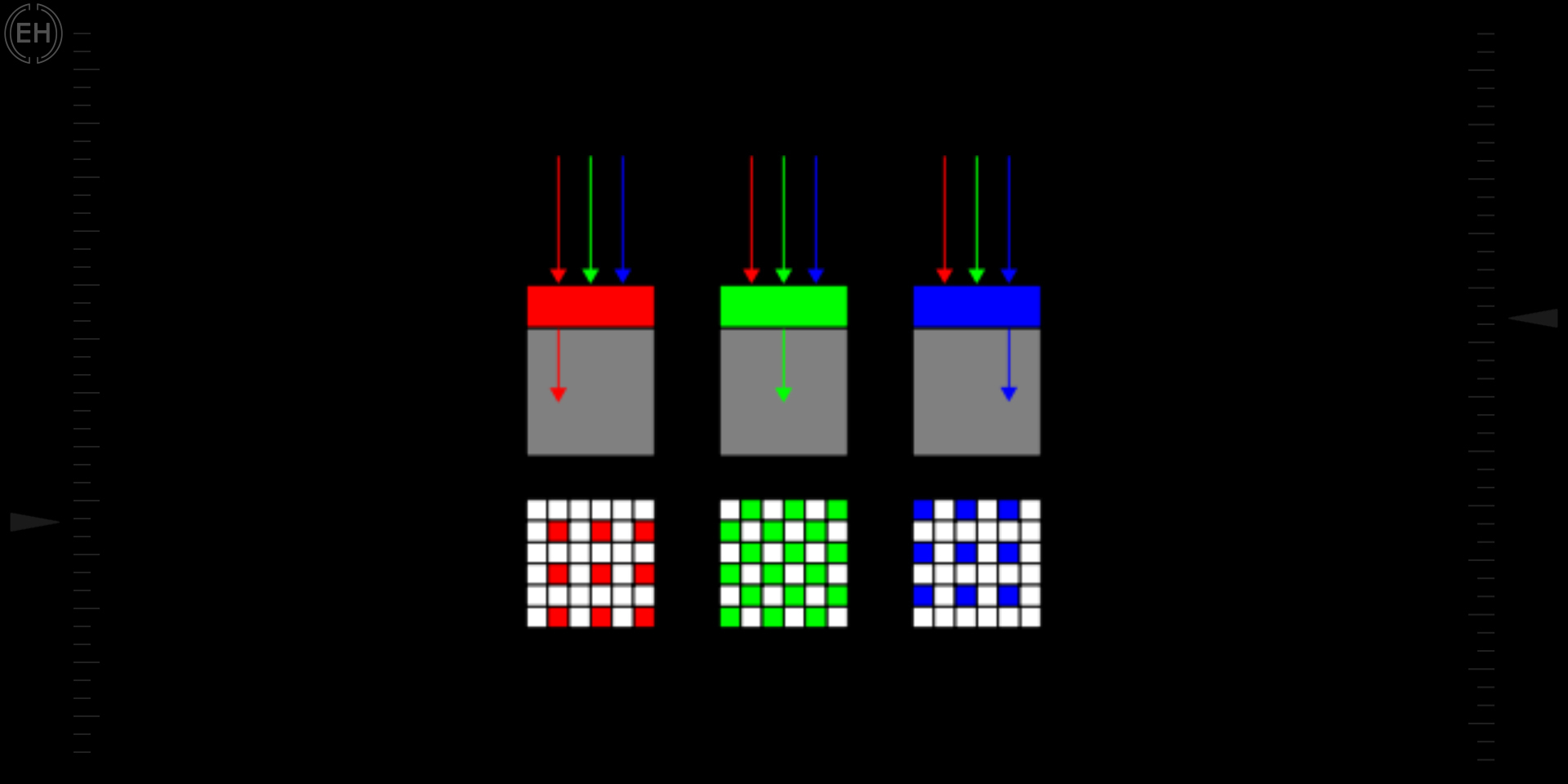

1. Der eigentliche Bildsensor kann keine Farben erkennen, nur die Stärke und Intensität der Lichtstrahlen. |  2. Um die Farben in der Szene zu erfassen, verwenden Kameras Bayer-Farbfilter vor dem Sensor, sodass durch jeden Pixel eine Farbe (rot, grün oder blau) durchkommt, so misst man die drei Farben. |

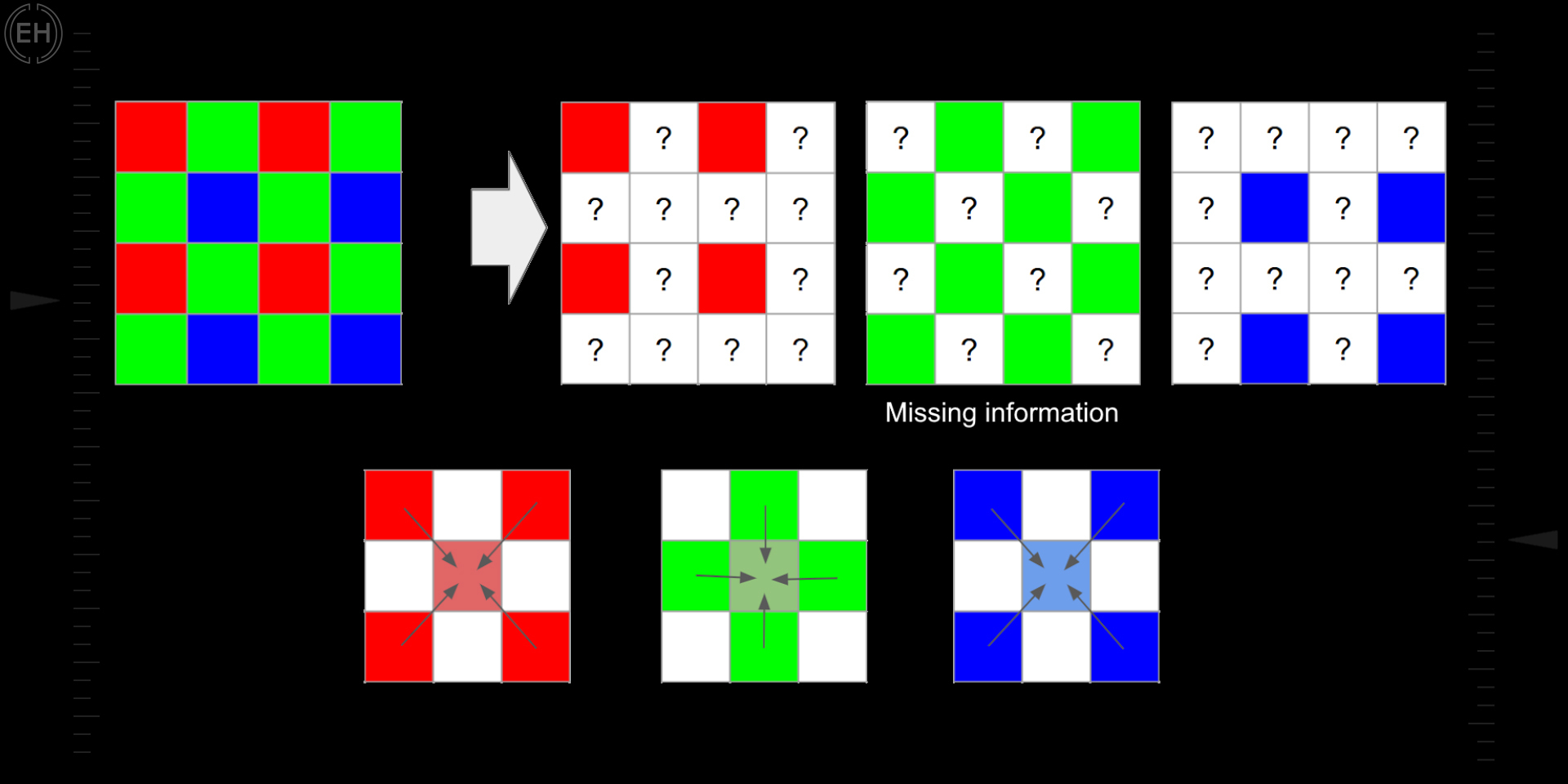

3. Das Problem hierbei ist, dass jeder Pixel nur eine einzige Farbe erkennen kann. Dann müsste das Bild doch ein Muster an rot, grün und blauen Punkten sein? |  4. Hier muss die Kameraverarbeitungspipeline dann die realen Farben unter Berücksichtigung der Teilinformationen rekonstruieren. Das ist ein Schätzen der fehlenden Farbinformationen durch die nahegelegenen Pixel. Zwei drittel eines digitalen RGB-Bildes sind eine Rekonstruktion. |

Diesen ganzen Vorgang nennt man dann Demosaicing.

Natürlich verwenden moderne Smartphones deutlich komplexere Technologien als diese, dennoch führt das zu unvollständigen Ergebnissen und Artefakten. Das Problem haben selbst große DSLR-Kameras. Wie will Google dieses lösen?

Seit mehr als einem Jahrzehnt kennt man die Technik Drizzle aus der Astronomie, wo Bilder vieler leicht verschiedener Perspektiven oder eher Positionen aufgenommen und kombiniert werden. Bei guten Lichtverhältnissen entspricht das eine Auflösung eines 2x oder 3x optischen Zooms.

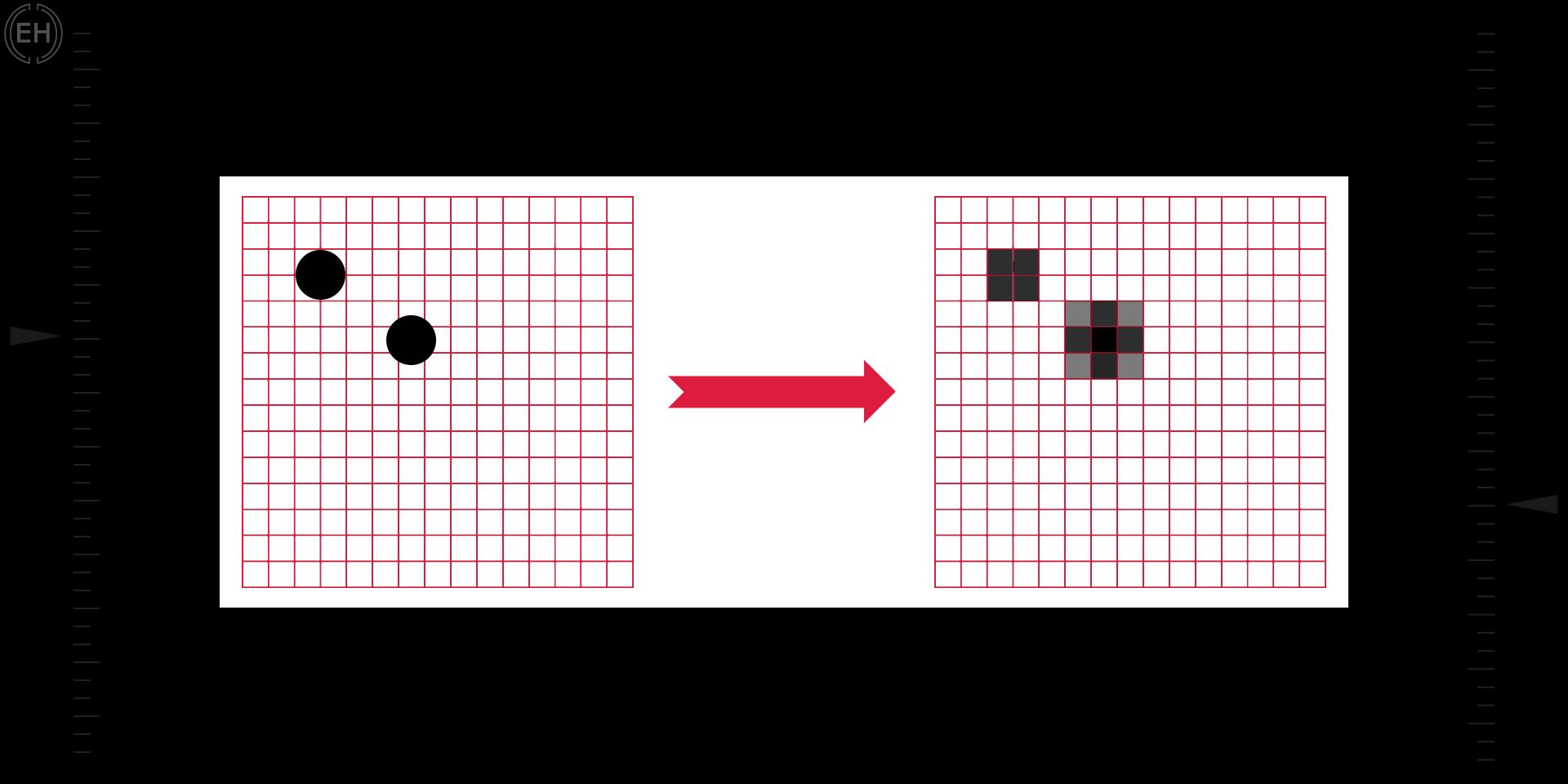

Diese Technik nennt man dann Multi-Frame Super-Resolution Algorithmus. Um es einfach zu sagen nehmen wir viele sehr niedrig aufgelöste Bilder aus unterschiedlichen Perspektiven, legen diese in ein hochauflösendes Feld und erhalten durch den Mittelwert, also die Pixel, die bei jeder Perspektive belegt sind, ein hochauflösendes Bild.

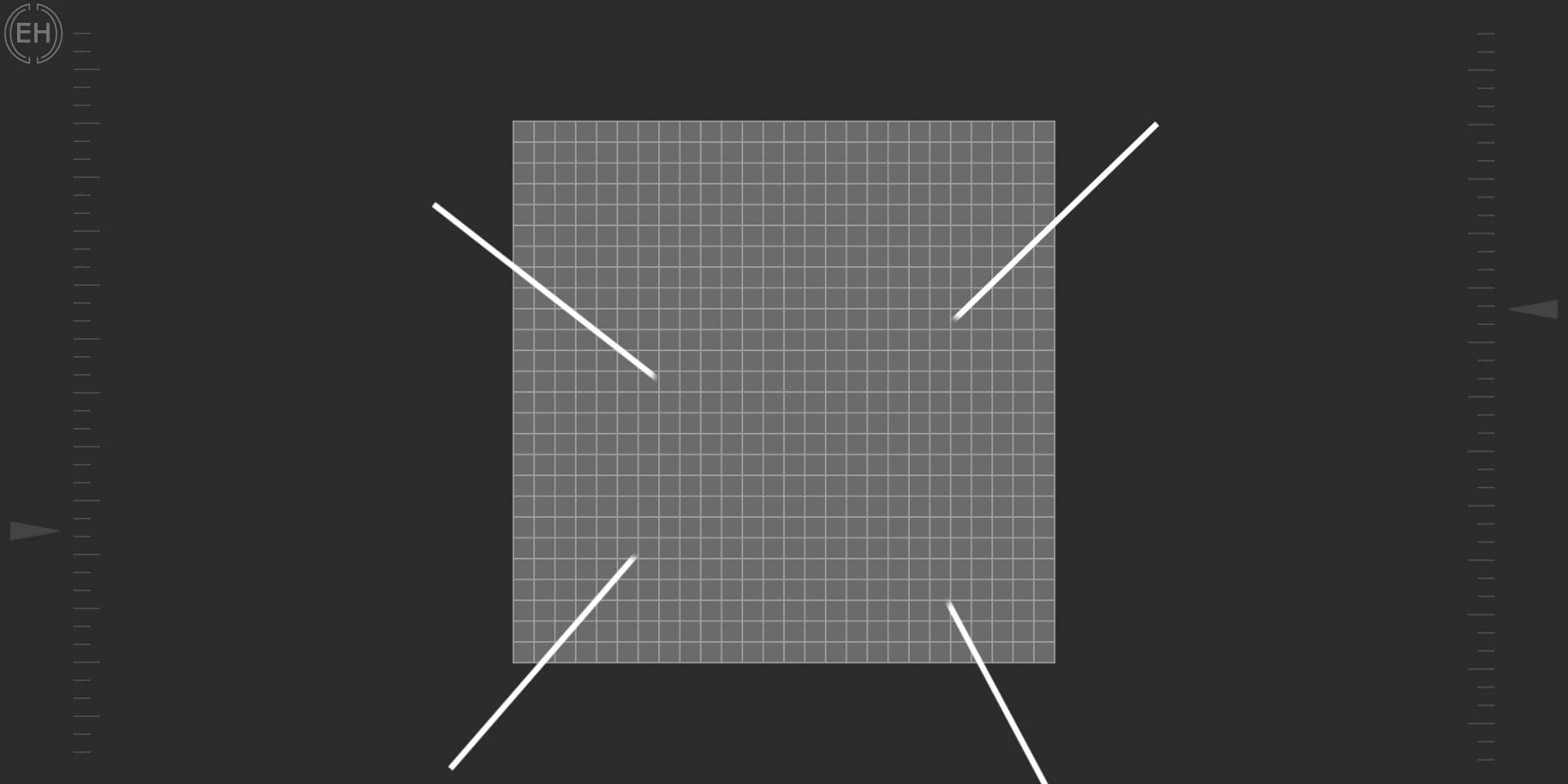

Hier mal ein Beispiel zum viel besseren Verständnis:

Achten wir mal auf diese hochauflösende Kreise links, wir verschieben sie in diesem Kästchenfeld. Wir sehen, der Kreis ist eigentlich gleich, aber die dadurch entstehenden, niedrig aufgelösten Bilder sind komplett unterschiedlich.

Ein hochauflösendes Bild des Buchstaben A habe ich leicht hin und her verschoben, alles auf eine sehr niedrige Auflösung skaliert und auch hier wie beim Kreis-Beispiel viele verschiedene Versionen erhalten:

Diese Bilder habe ich nun in Photoshop verschoben und den Mittelwert durch die Stacking-Funktion berechnet.

Wir sehen, wir erhalten wieder ein hochauflösendes Bild des Buchstaben A.

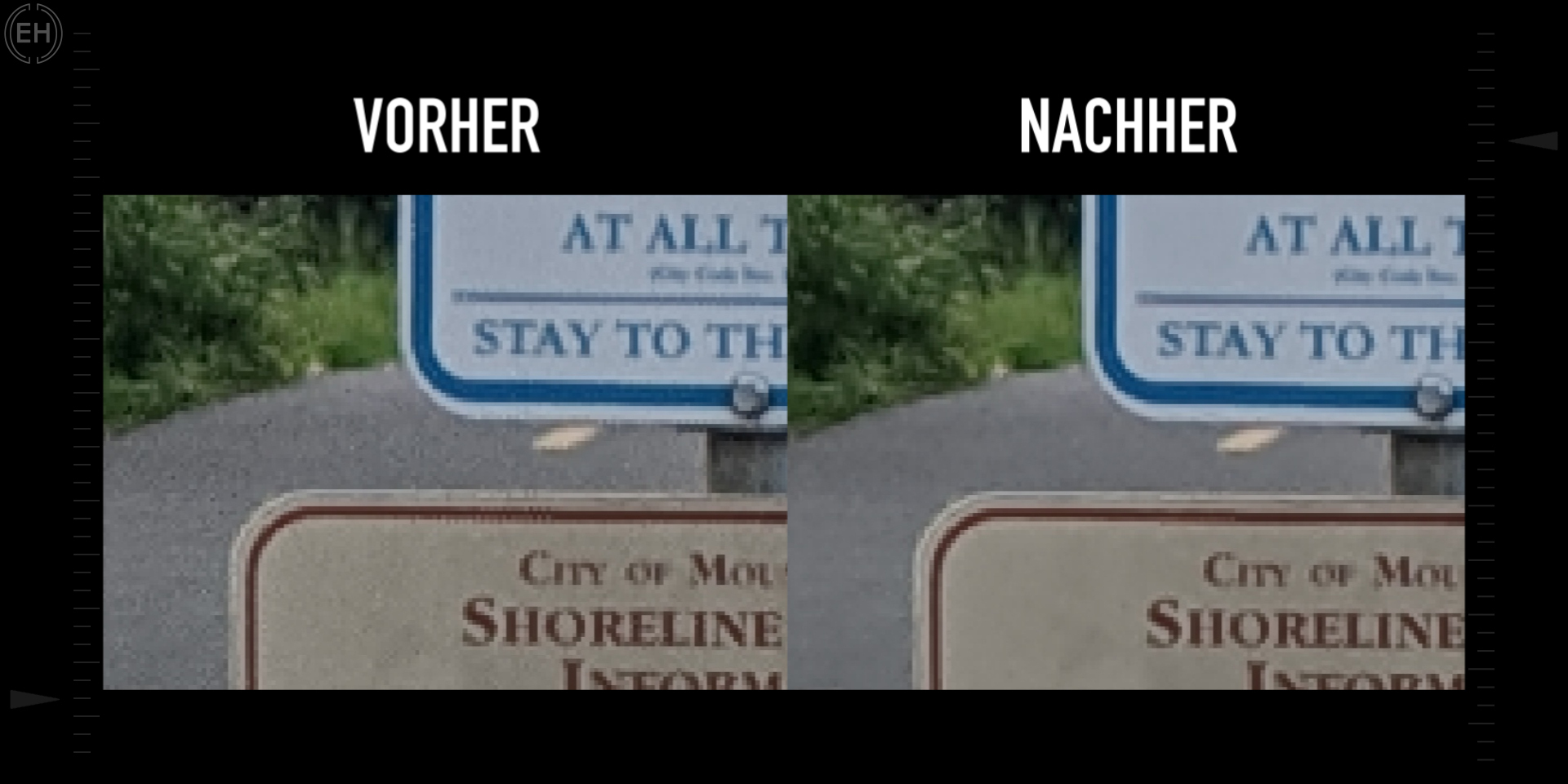

Das Gleiche haben wir auch mit einem von Google zur Verfügung gestelltem Beispielbild gemacht, wir erhalten auch hier ein hochauflösendes Bild als Ergebnis:

Vorher |  Nachher |

Die Wichtigkeit liegt hierbei auf die Anzahl der unterschiedlichen Positionen. Aber wie bekommt Google diese überhaupt? Bei großen Kameras oder in der Astronomie gibt es dafür spezielle Technologien, aber bei mobiler Fotografie haben wir einen sehr natürlichen Vorteil: Das unbewusste Wackeln deiner Hand während dem Fotografieren. Durch diese leichten Bewegungen bekommen wir viele Bilder aus unterschiedlichen Winkeln. Durch die optische Bildstabilisierung werden dann noch zu starke Bewegungen ausgeglichen.

Wenn du aber dann ein Stativ verwendest und keine Verwacklung mehr hast, was dann? Das ist noch interessanter von Google gelöst. Sie bewegen das Modul der optischen Bildstabilisation dazu, sich leicht zu bewegen. Komisch, oder? Eine Stabilisierung, die zum Verwackeln verwendet wird. Diese Bewegung ist wirklich sehr klein und stört beim Fotografieren nicht.

Dennoch erkennt man sie, wenn man den digitalen Zoom des Pixel maximiert.

Aber: Oben haben wir ein sehr flüssiges, scheinbar einfaches Schema erklärt. Für die Verständlichkeit wurde dieses natürlich vereinfacht. Wenn jeder Schritt wirklich so perfekt funktionieren würde, hätte die Technologie wahrscheinlich bereits jedes Smartphone. Es gibt Gründe, warum es bisher nur Google gerissen hat.

Erstens ist die Sensorgröße der Smartphones beschränkt. Selbst bei ausreichender Helligkeit kann es sein, dass aufgrund der zu niedrigen Belichtung jedes Bild sehr viel Rauschen beinhaltet.

Zweitens: Beim Fotografieren kann sich neben der Hand auch noch das Motiv bewegen, zum Beispiel Blätter an einem Baum, Autos, Mitmenschen etc. Das alles ist störend für Multi-Frame Super-Resolution. Zudem sind die Bewegungen der Hand und der Motive alle zufällig verteilt. Selbst wenn die Bilder gut abgestimmt werden können, können die Bildinformationen ungleichmäßig sein. Viel weiter möchte ich das gar nicht ziehen, um den Beitrag im Rahmen zu behalten. Deswegen: Wie löst denn das Google Pixel nun die Probleme? Zunächst wählt es ein Bild aus den Frames aus mit der besten Schärfe als Referenz. Anschließend wird dieses Bild mit den anderen verglichen und analysiert. Hier werden die Bilder aber nicht komplett Pixel für Pixel verglichen, sondern die Details eins für eins, um so die gleichen Einstellungen mit der Referenz, also die richtigen Einstellungen, zu finden. Danach werden erst die Informationen der anderen Bilder kombiniert. Das war sogar noch nicht alles.

Das Google Pixel findet durch Software die Ränder von Objekten im Bild und kombiniert die Pixel entlang dieser Ränder. So werden nicht nur die Details behalten, sondern die Ränder werden klarer. Daher sehen wir, dass bei gleicher Auflösung, sogar bei gleichem Sensor, dass Google mehr Details einfangen kann.

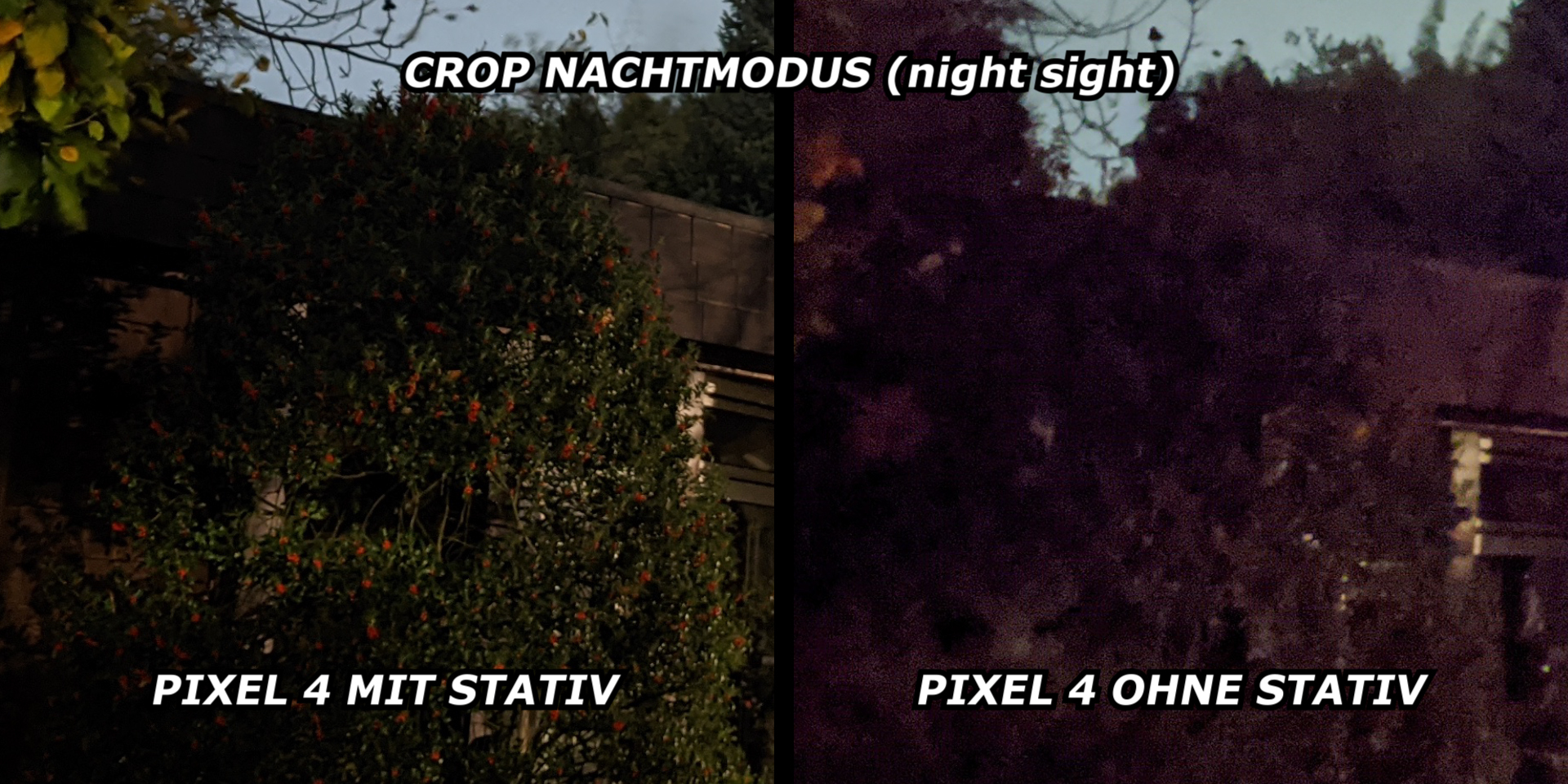

Nachtaufnahmen

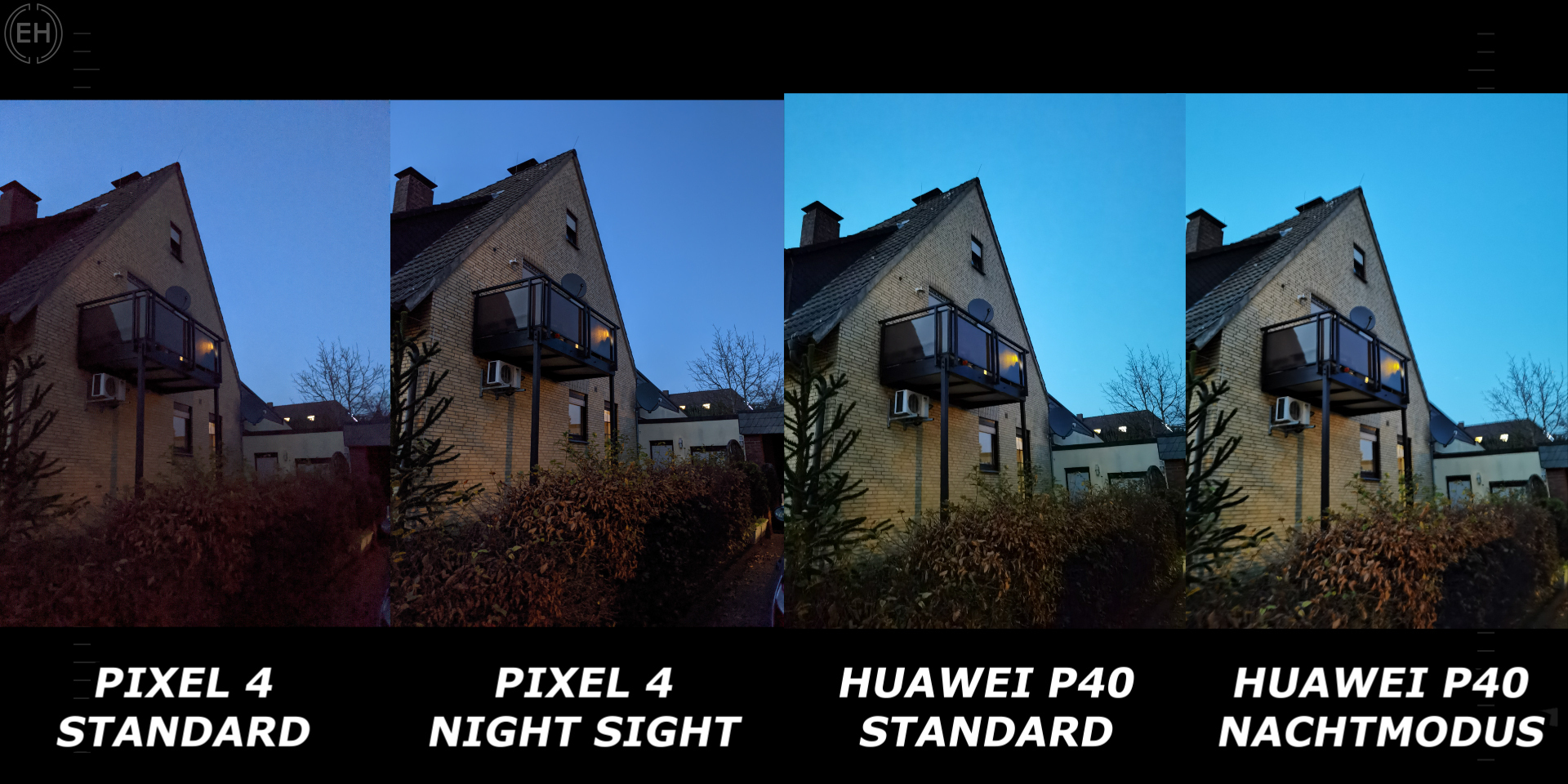

Wo wir nicht mehr so extrem ausführlich drauf eingehen werden sind die Nachtaufnahmen. Auch hier hat Google sehr gute Ergebnisse im Night Sight Nachtsicht-Modus, wo ebenfalls eine Langzeitbelichtung wie bei anderen Konkurrenten durchgeführt wird. Bei Stockdunkelheit im Vergleich zu Huawei und ihren Nachtsichtgeräten gibt es noch einen Unterschied, aber bei etwas Licht im Nachtmodus und Vergleich zum normalen Huawei P40 schneidet das Pixel wegen dem OIS besser ab.

|

|

Huawei nimmt hier oft verwaschene Bilder auf.

Aufnahmen ohne Nachtmodus oder im Vergleich mit einem P40 Pro mit OIS etc. brauchen wir nicht zu vergleichen. Zumal sie einen riesigen RYYB Sensor und auch gute Software haben.

Die Frage ist nur: Was hätte Google mit einem großen Sensor und ihrer Software erreichen können?

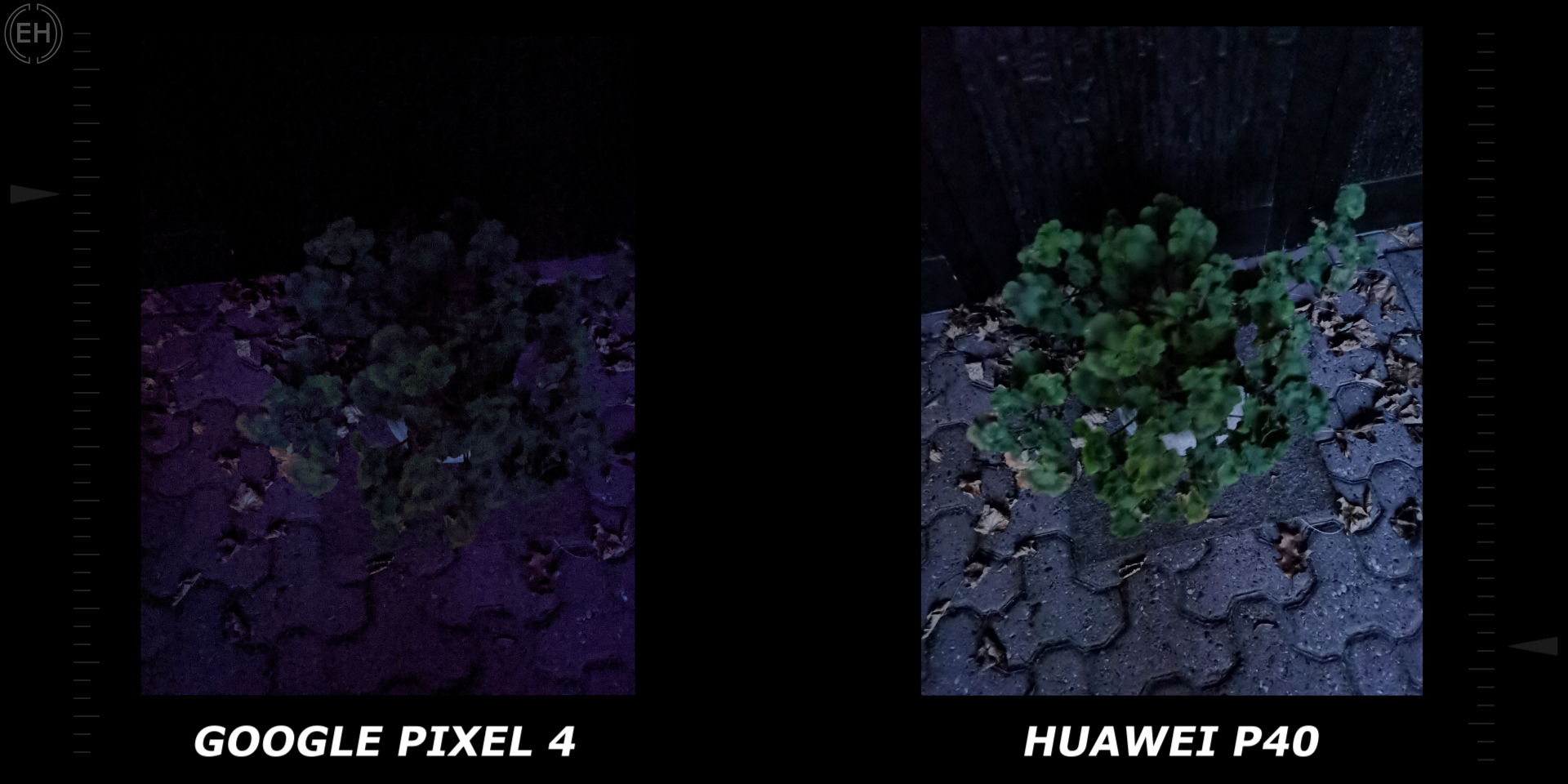

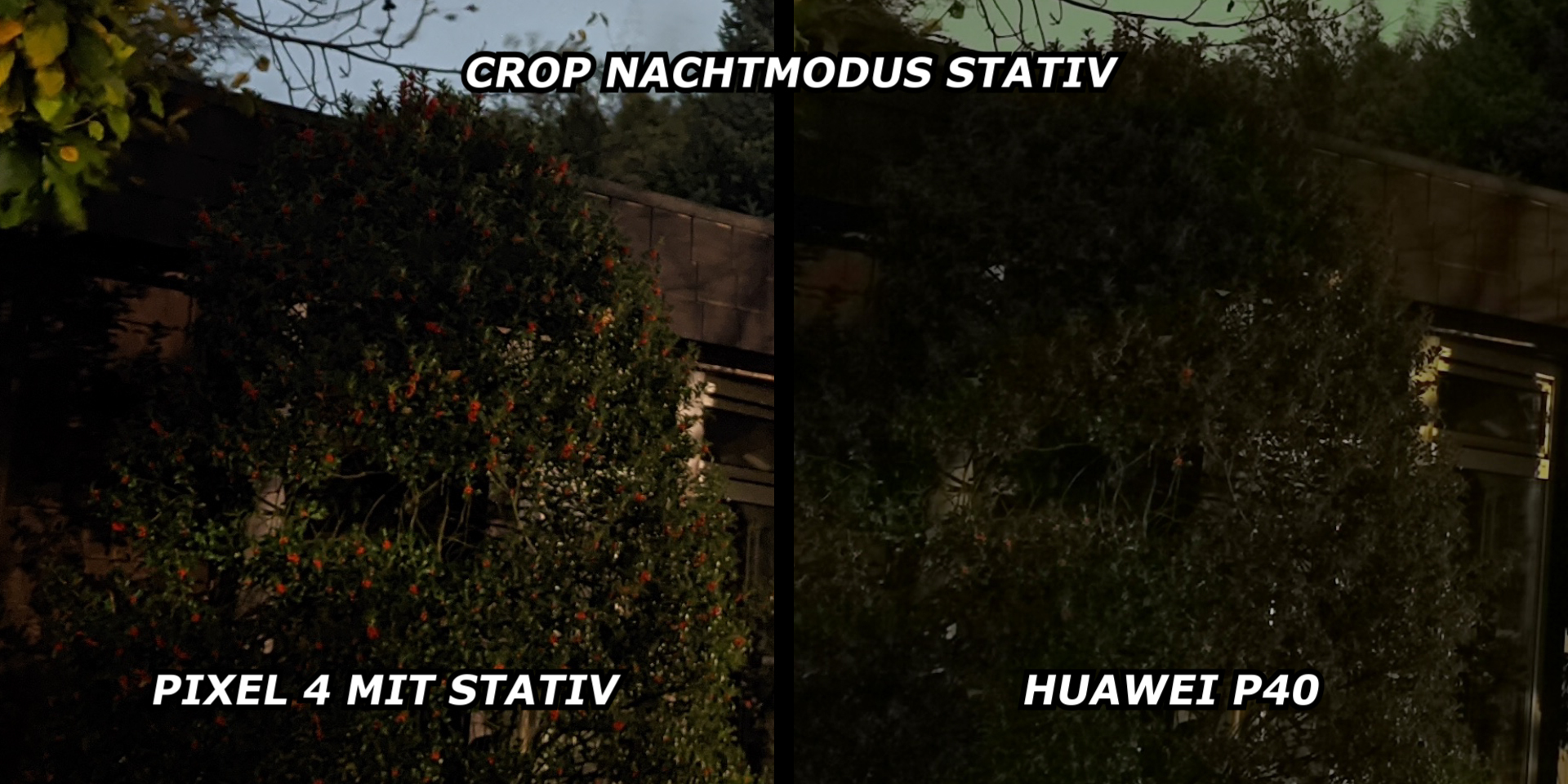

Legen wir beide Handys nacheinander auf ein nicht wackelndes Stativ. Wenn wir jetzt den Nachtmodus benutzen haben die meisten Smartphones eine Funktion, dass sie sehr lange für mehr Details belichten.

Google Pixel 4 |  Huawei P40 |

Google direkt ca. 3 Minuten, beim P40 sind es ca. 25 Sekunden. Das spiegelt sich auch in den Ergebnissen wider. Google ist hier 2 Schritte vor allen anderen und fängt in Stockdunkelheit mehr Details ein als jeder Konkurrent. Wer diese 3 Minuten Geduld hat, sollte die Zeit definitiv investieren.

Beide auf Stativ |  Beide auf Stativ (Zoom in) |

Porträtmodus

Beim Porträtmodus, dem auch besten auf dem Markt im Pixel, verwendet es schon seit dem Pixel 2 künstliche neuronale Netzwerke, künstliche Intelligenz zur Trennung vom Motiv zum Hintergrund und bekommt dann Tiefeninformationen. Beim Pixel 4 ist die zweite Kamera noch hilfreicher als der Dual-Pixel Fokus zuvor.

Ende

Das ist also die Google Kamera. Bei so einem leichten Klick auf den Auslöser greift Google hinter der Fassade auf eine Reihe von künstlicher Intelligenz, maschinelles Lernen usw. zurück. Vielleicht die krasseste Software auf dem Markt. Man braucht sich nicht mehr wundern, warum die Kamera aus so schlechten Sensoren so gute Ergebnisse rausholen kann. Das ist vielleicht auch ein kleiner Spott an die meisten anderen Android-Hersteller. “Ihr benutzt so krasse Hardware, weil ihr die Software überhaupt nicht in den Griff bekommt”. Wenn wir mit dem neu bekommenen Wissen einmal über das etwas hässliche Google Pixel 4 rüber schauen, ist das ein Gefühl, in dem ich die Ränder überhaupt nicht mehr sehen kann.

Vielen Dank für eure Zeit! ![]()